Исследователи доказали: механизм «безопасного» редактирования LLM сам по себе является каналом утечки данных. Атака KSTER восстанавливает отредактированные данные с точностью recall свыше 99% на модели Llama3-8B-Instruct*.

Метод locate-then-edit — mainstream-парадигма редактирования LLM — изменяет параметры модели без переобучения, чтобы удалить чувствительные данные. Однако если атакующий получает доступ к весам до и после редактирования, он может восстановить именно те данные, которые были стерты — анализируя разницу параметров. Это превращает механизм защиты приватности в уязвимость.

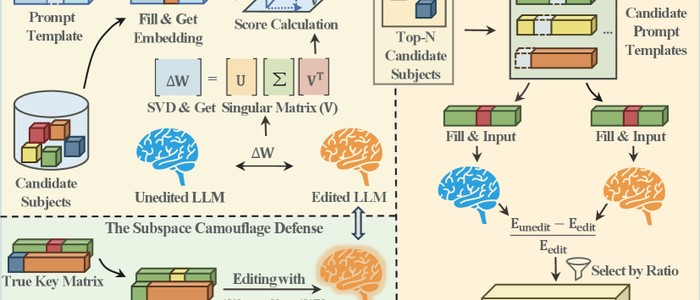

KSTER работает в два этапа: сначала реконструирует ключевое подпространство (key space) через SVD-анализ матрицы обновления весов, затем восстанавливает семантический контекст через анализ энтропии. Математически исследователи доказали: row space матрицы ΔW кодирует уникальный «отпечаток» отредактированных субъектов. Атака показала recall 0.94–1.00 по субъектам и top-20 recall 0.94–0.99 по промптам на датасете CounterFact.

В качестве защиты исследователи предложили subspace camouflage: в процессе обновления весов инжектируются семантические «приманки» — ключевые векторы несвязанных субъектов.

*Компании и продукты, признанные экстремистскими и запрещены в РФ.

Источник новости и обложки: arxiv.org