Исследователи из MIT и Google DeepMind представили пайплайн, позволяющий роботу собирать многокомпонентные физические объекты по текстовому промпту. В серии экспериментов пользователи предпочли сборку под управлением VLM в 90,6% случаев, в то время как алгоритмы на основе правил набрали лишь 59,4%. Система использует манипулятор UR20 для физического воплощения сгенерированных конструкций.

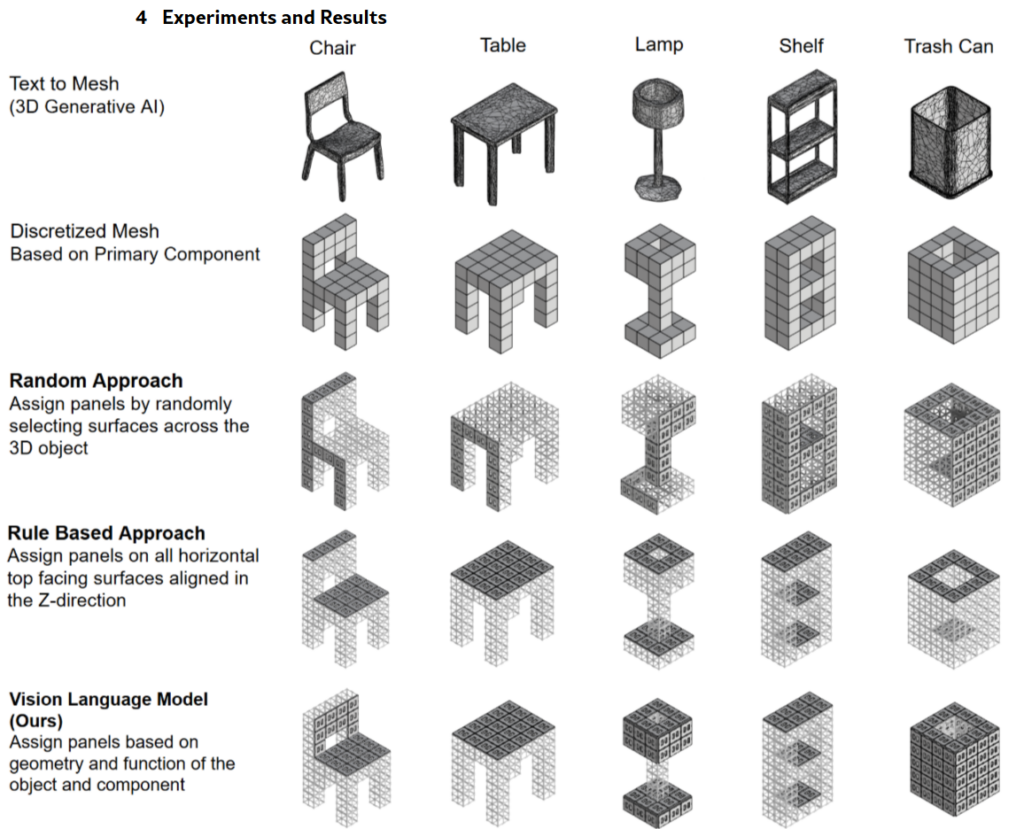

Основная проблема заключалась в том, что 3D-генеративные модели создают монолитные меши, лишенные компонентной структуры для планирования сборки. Существующие эвристические методы, размещающие панели на всех направленных вверх поверхностях, справляются со столами, но ошибаются на сложных объектах вроде ламп. Случайное распределение компонентов показало эффективность всего 2,5%.

Для решения задачи используется модель Gemini 2.5 pro, которая выполняет мультимодальное zero-shot рассуждение над геометрией и функциональностью. VLM анализирует аксонометрическое изображение меша и текстовое описание, разделяя объект на структурный каркас и функциональные панели. Модель сопоставляет необходимые детали с метками граней на дискретизированной сетке, исключая недоступные для робота зоны.

Система поддерживает итеративное уточнение через диалог, позволяя пользователю корректировать размещение компонентов естественным языком. Это доказывает, что VLM способны декомпозировать сгенерированные меши на физические детали без специального обучения. Статистический тест Макнемара подтвердил значимое преимущество подхода над базовыми алгоритмами.

Источник новости и обложки: arxiv.org