Данная статья является переводом. Ссылка на оригинал.

Генеративные предобученные трансформеры (GPT) называют революцией в робототехнике, но насколько это обосновано? Применение GPT в автономных роботах требует огромных вычислительных ресурсов, длительного обучения и часто удаленного управления. Мы сравниваем современные GPT с крошечным мозгом насекомых, обеспечивающим надежную автономность без этих ограничений, и предлагаем биологические принципы для повышения эффективности GPT в робототехнике.

Введение

Последние годы ознаменовались прорывом в генеративном ИИ благодаря архитектуре трансформеров (GPT). Механизм внимания в глубоких нейросетях и обучение на масштабных данных привели к развитию больших языковых моделей (LLM), а затем и мультимодальных систем для генерации изображений и видео.

Успехи трансформеров вдохновили их применение в робототехнике, где традиционно сложно создавать одновременно универсальные и надежные системы. Предполагается, что масштабное предобучение с последующей специализацией может решить эту проблему. Такие подходы получили название «фундаментальных моделей», что указывает как на их потенциал, так и на незавершенность.

Однако у LLM есть существенные ограничения: огромные требования к данным и вычислительным ресурсам, высокие финансовые и экологические затраты, проблемы с надежностью. Мы ставим под вопрос, действительно ли трансформеры станут основой робототехники и лучшим путем к искусственной автономии.

В отличие от расплывчатого понятия «интеллект», уровень автономности робота хорошо определен, измерим и экономически значим. Мы утверждаем, что трансформеры создают лишь видимость автономии, а не истинную самостоятельность. Контраст между GPT-подходами и биологическими решениями, реализованными в мозге животных, поразителен. Анализируя эти различия, мы выявляем недостатки текущих GPT-систем и предлагаем пути повышения надежной автономности роботов.

Прогресс применения трансформеров в робототехнической автономии

Трансформеры активно внедряются в робототехнику. Помимо громких коммерческих анонсов, комплексные решения для автономных роботов разрабатываются научными и промышленными группами, особенно в задачах навигации и манипуляций.

Несмотря на первые успехи, эта технология сталкивается с серьезными ограничениями. Хотя некоторые проблемы могут смягчиться по мере оптимизации, в архитектуре трансформеров существуют фундаментальные структурные недостатки, требующие поиска альтернативных подходов.

Растущие требования к данным и затратам

В основе трансформеров лежит масштабирование. Не имея встроенных предубеждений, эти системы крайне гибки, но требуют огромных объемов данных. Типичный подход включает предобучение на большом объеме данных с последующей специализацией на конкретных задачах.

Затраты колоссальны: современные языковые модели обходятся в десятки или сотни миллионов долларов за один цикл обучения, хотя эти расходы постепенно снижаются. Для робототехники требуется дополнительное обучение специфическим задачам.

Доступность качественных данных становится серьезной проблемой. Предлагаемые решения включают открытые датасеты и физические симуляторы, но для поддержания прогресса потребуются экспоненциально растущие объемы информации.

Для робототехники сбор полезных данных особенно затратен. Замена физического сбора на симуляцию просто меняет экспериментальное время на вычислительное. Более того, улучшение производительности трансформеров требует увеличения масштаба данных и весов, что только усугубляет проблему.

Сохраняющиеся вычислительные требования

После оплаты обучения затраты на вывод все равно значительны. Например, Llama 3.1* от Meta* имеет облачные версии (405 млрд параметров) и уменьшенные локальные варианты (8 млрд параметров), требующие ~10-100 ГБ памяти. Это означает необходимость мощного графического процессора даже для простейших моделей.

Масштаб проблемы для трансформеров на порядки больше, чем для традиционных нейросетей. Современный алгоритм обнаружения объектов имеет 10-80 млн весов по сравнению с 8-405 млрд весов языковой модели — разница в четыре порядка.

Ведутся исследования по преодолению узкого места облачных вычислений, включая технологии 6G. Закон Мура традиционно помогал развитию ИИ, но для фундаментальных моделей экспоненциальный рост требований может перевесить рост вычислительных мощностей.

Реальное снижение требований произойдет только если скорость роста доступных вычислений превысит скорость роста потребностей моделей. Однако есть признаки наступления эпохи «после закона Мура», требующей инноваций в материалах. Даже с учетом алгоритмических улучшений, разрыв между возможностями трансформеров и биологическими решениями автономии остается огромным.

Галлюцинации трансформеров в робототехнике: серьезная проблема

Из-за статистической природы обучения языковые модели склонны к галлюцинациям — генерации контента, противоречащего реальным знаниям. Если для виртуального ИИ это опасно, то для воплощенного в роботе трансформера риски многократно возрастают — подобно тому, как галлюцинации при психических расстройствах у людей могут привести к вреду.

Уже продемонстрированы успешные атаки на защитные механизмы робототехнических трансформеров. Хотя смягчение галлюцинаций активно исследуется, корреляционная природа трансформеров делает их неизбежными. Сбои характерны и для символических рассуждений GPT, и для моделей с цепочками рассуждений.

Это потребует либо постоянного присутствия человека в контуре управления, либо изоляции роботов от людей, что существенно ограничит потенциал робототехники. Без значительных архитектурных изменений эти структурные проблемы статистических подходов вряд ли найдут решение.

Иллюзия интеллектуальной автономии

Почему же трансформеры все активнее применяются в робототехнике? Во-первых, достигнуты впечатляющие прорывы в традиционно сложных областях: управлении гуманоидами, манипуляциях, интерфейсах на естественном языке. Во-вторых, склонность людей к антропоморфизации приводит к приписыванию моделям способностей, которыми они технически не обладают.

В основе трансформера лежит повторяющийся блок Self-Attention с последующим блоком многослойного перцептрона. Поток управления однонаправленный, а механизм внимания обучается фокусироваться на релевантных элементах входных данных при прогнозировании следующего действия. Мощь трансформеров происходит из масштабного предобучения, позволяющего сопоставлять входные данные с прогнозируемым выходом.

В робототехнике трансформеры успешно определяют действия на основе ввода, но это достигается интерполяцией и экстраполяцией обучающего набора, с ненадежной работой вне его рамок. Здесь нет рассуждений, а выбор варианта основан лишь на выборе наибольшего предсказательного веса согласно обучению. То же касается языковых способностей больших языковых моделей, которых называют «стохастическими попугаями».

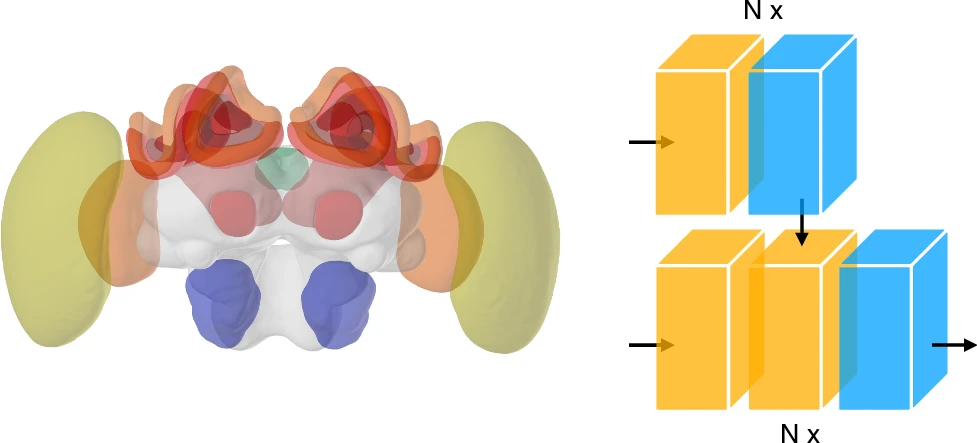

Справа: Архитектура GPT. Входные данные преобразуются в многомерные векторы и обрабатываются повторяющимися блоками механизмов внимания (желтые) и прямонаправленных нейросетей (синие). Каждый блок — это огромная матрица, а последовательные матричные умножения формируют выходные данные. Знания закодированы в значениях матриц, содержащих миллиарды или триллионы элементов. Хотя GPT имеет больше параметров, чем синаптических связей в простом мозге, его поведенческие реакции менее надежны.

Обучение и обращение к опыту важны и для биологического принятия решений, но у людей и животных оно также опирается на модели мира, понимание других агентов и соответствие действий ситуации. Трансформеры лишены этих моделей. Возможности робота ограничены объемом обучающих данных, а его ответы не имеют обоснования кроме статистической ассоциации.

Это создает проблемы для взаимодействия человека с роботом. Если человек может объяснить логику своей ошибки, то робот на основе трансформера даст ответ, имеющий в лучшем случае корреляцию с ошибкой, но не причинно-следственную связь, и подверженный галлюцинациям. Однонаправленные трансформеры структурно неспособны к надежному метапознанию и самоанализу.

Альтернативы трансформерам для автономных систем

Естественный интеллект

Разрыв между трансформерами и биологическим мозгом огромен. Показательно сравнение не только с человеческим мышлением, но и с интеллектом животных.

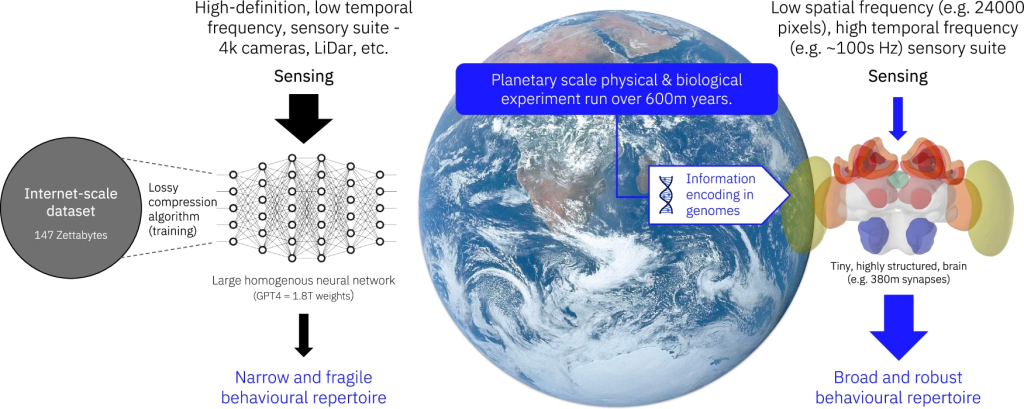

Мозг пчелы объемом всего один кубический миллиметр содержит менее миллиона нейронов и около полумиллиарда синапсов. Этого достаточно для навигации на расстояния в несколько километров, сбора пыльцы и нектара, общения с сородичами и поддержания колонии. Пчелы решают сложные задачи поиска ресурсов, собирая их с труднодоступных цветов.

Поразительно, что пчелам не требуется практика для полета, а всего 20 минут облета улья хватает для уверенной навигации. Контраст с длительным обучением трансформеров разителен. Энергопотребление мозга пчелы ничтожно по сравнению с любой GPT-моделью.

В отличие от трансформеров, мозг животных прошел огромное эволюционное «предобучение», позволяющее генерировать широкий спектр поведений при минимуме информации. Хотя невозможно повторить эволюционный процесс, охватывающий триллионы особей миллионов видов за сотни миллионов лет, мы можем изучать его конечный результат — воплощенный мозг.

Источники: NASA (Земля), insectbraindb.org (мозг пчелы, CC BY 4.0)

Секрет эффективности — структура

Как скромной пчеле удается превзойти трансформеры? Ответ — в структуре. Если трансформеры до предобучения структурно не дифференцированы, то мозг насекомых — учебник специализации структуры и функций.

Мозг насекомых разделен на модули, каждый из которых специализируется на обработке определенных аспектов автономного принятия решений. Каждая специализация использует закономерности обрабатываемой информации для снижения вычислительной нагрузки.

Например, специализированные модули обрабатывают поляризованный свет в небе — надежный навигационный ориентир. Его структура сохраняется топографическим процессором (протоцеребральным мостом), функционирующим как кольцевой аттрактор — сеть нейронов, которая обрабатывает входную информацию от сенсорных систем для определения ориентации относительно внешних сигналов.

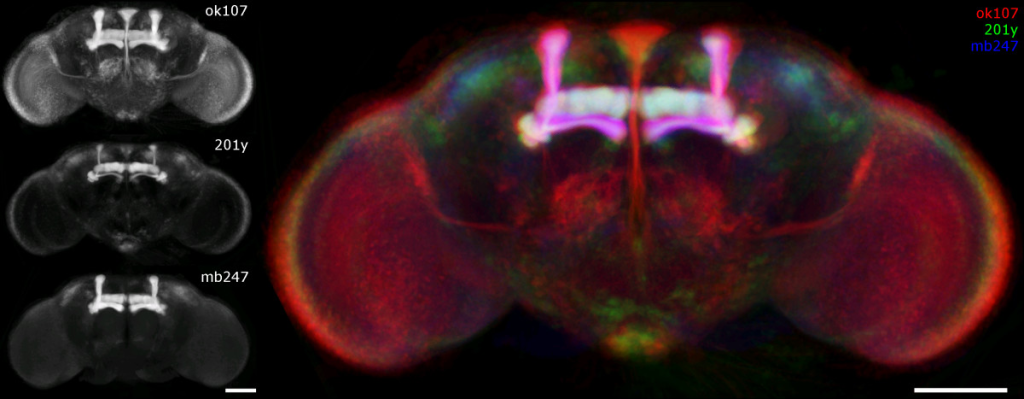

Закономерности внешнего мира отражаются в структуре мозга насекомого, что обеспечивает своеобразную «интуитивную физику». Сенсорные доли специализированы под свои области, они обрабатывают и сжимают сигналы для передачи в зоны сенсорной интеграции. Крупнейшая из них — грибовидное тело — структурно напоминает трехслойную нейросеть с расширенным средним слоем, что эффективно для мультимодальной классификации.

Хотя насекомым не свойственно декларативное мышление, их рассуждения строятся вокруг элементарной модели мира. Они обладают целостным представлением о пространстве с перспективой от первого лица. ИИ может получить огромную пользу от заимствования концепций из нейробиологии насекомых.

Объективный ИИ и модели мира

Другие исследователи также предлагают вдохновляться способностями животных, но менее буквально. Подход «объективного ИИ» предлагает модульные архитектуры, соответствующие пониманию человеческого мозга из нейронауки и когнитивной психологии.

Вместо прямого воспроизведения специализированных нейронных цепей/схем предлагается проектирование взаимодействующих обучаемых модулей, способных генерировать более адаптивное поведение, чем крупные недифференцированные нейронные сети. Ключевой аспект — внедрение явных и конфигурируемых моделей мира, вдохновленных когнитивной наукой, но при этом обучаемых на данных. Например, вместо реверс-инжиниринга детекторов признаков в зрительной системе приматов предлагается обучать такие модули с нуля.

Гибридные подходы к автономным системам

Нейросимволический подход

Опираясь на давние идеи и получая новый импульс от современных разработок, исследователи предлагают «нейросимволический подход». Суть его в том, что глубокие сети хорошо справляются с перцептивными задачами (обнаружение объектов), но принципиально не подходят для символических манипуляций, необходимых для рассуждений и планирования.

Недавние наблюдения подтверждают, что языковые модели не могут надежно работать с символическими знаниями. Поэтому предлагается объединить перцептивные сильные стороны статистического ИИ с причинно-следственными преимуществами символического подхода.

Учитывая, что нейронные основы символического мышления в мозге изучены слабо, это весьма прагматичный подход. Есть надежда, что ограничения первой волны символического ИИ будут преодолены благодаря тому, что ему не придется в одиночку справляться с перцептивной сложностью реального мира.

Еще более мощное сочетание могло бы включать подходы Естественного Интеллекта к восприятию и моделированию пространства с набором вариантов решений.

Место трансформеров в гибридных системах

Трансформеры могут обогатить наше понимание «высших» когнитивных функций мозга и по-прежнему представлять ценность как компонент полного стека автономных систем, основанного на механизмах, заимствованных из естественного мозга.

Подобно тому, как активность в глубоких нейронных сетях коррелирует с функциями естественного мозга, трансформеры улавливают некоторые фундаментальные аспекты языка и визуального воспроизведения (хотя это и оспаривается). Они могут стать частью полностью автономной системы, построенной на более прочном фундаменте.

Заключение

Архитектуры трансформеров принесли в робототехнику тот же быстрый прогресс, что и в обработку естественного языка и мультимодальный ИИ. Однако есть основания продолжать поиск решений проблемы автономности роботов.

Трансформеры рассматривают мир в чисто статистических терминах. И результатом становится решение, очень отличающееся от единственного по-настоящему автономного объекта — биологического мозга.

* Llama принадлежит компании Meta, деятельность которой признана экстремистской и запрещена на территории РФ