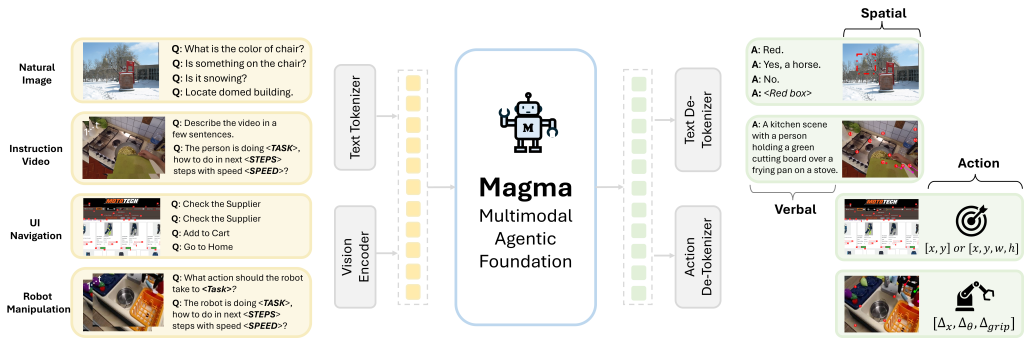

Исследователи Microsoft Research совместно с учеными из нескольких университетов представили Magma — первую модель, способную не только понимать мультимодальные данные, но и взаимодействовать с физическим миром. В отличие от существующих моделей, которые в основном работают с текстом и изображениями, Magma может планировать и выполнять реальные действия для достижения поставленных целей.

Модель обучена на масштабном наборе данных, включающем изображения, видео и данные робототехники. Для разметки интерактивных объектов (например, кнопок в интерфейсе) используется технология Set-of-Mark (SoM), а для отслеживания движений (например, траектории роботизированной руки) — Trace-of-Mark (ToM). Эти инновации позволили модели достичь 100% точности в задачах навигации по пользовательским интерфейсам.

В тестах на управление реальным роботом-манипулятором WidowX модель Magma продемонстрировала впечатляющие результаты, значительно превзойдя существующие решения вроде OpenVLA. Особенно важно, что модель показала высокую эффективность даже при работе с 5 примерами обучения, что открывает широкие перспективы для быстрой адаптации к новым задачам.

Несмотря на меньший объем обучающих данных, Magma показала конкурентоспособные результаты в сравнении с современными моделями вроде Video-Llama2 и ShareGPT4Video в задачах понимания видео. Модель способна не только описывать происходящее, но и предсказывать дальнейшее развитие событий, что делает ее перспективной для применения в различных областях — от умных домов до промышленной робототехники.

Источник новости и обложки: microsoft.github.io